MINING MENGGUNAKAN NVIDIA GEFORCE RTX 2080 Ti

Pada tanggal 23 September lalu, NVIDIA mengeluarkan graphic card terbaru yaitu NVIDIA GEFORCE RTX 2080 Ti. Pada zaman sekarang ini banyak machine learning dan mining menggunakan GPU terbaru. GPU yang terkenal digunakan sampai saat ini yaitu NVIDIA GEFORCE GTX 1080 Ti. Kita akan membahas seberapa besar perbedaan performa kedua GPU dalam melakukan machine learning.

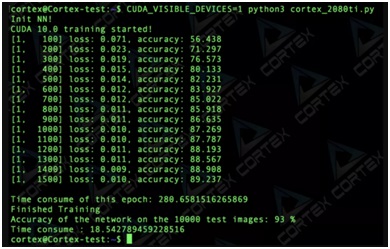

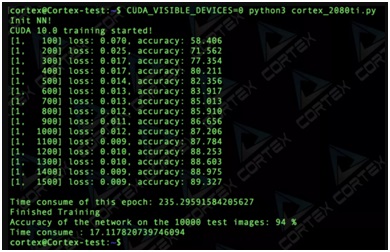

Machine learning adalah cabang aplikasi dari artificial intelligence yang fokus pada pengembangan sebuah sistem yang mampu belajar sendiri tanpa harus berulang kali diprogram oleh manusia. Dalam penggunaan kedua GPU dalam mengetes 10000 test gambar, kedua GPU menghasilkan akurasi yang kurang lebih sama, RTX 2080 Ti lebih unggul 1% dalam melakukan tes akurasi.

RTX 2080 Ti memiliki akurasi akhir 94% dalam mengetest 10000 image, sedangkan GTX 1080 Ti hanya 93%. Epoch pada RTX 2080 Ti lebih sedikit dibandingkan dengan GTX 1080 Ti yang menandakan machine learning pada RTX 2080 Ti belajar dengan lebih cepat. Epoch sendiri adalah banyaknya iterasi yang dibutuhkan dalam 1 proses untuk mempelajari sebuah subjek tes ANN (Artificial Neural Network). Waktu yang dibutuhkan untuk mengetest 10000 image terpaut 1 detik di mana RTX 2080 Ti lebih cepat.

Sumber :

- https://medium.com/cortexlabs/nvidia-geforce-rtx-2080-ti-mining-review-to-50-mh-s-and-beyond-43f126938fd1

- https://teknosains.com/amp/others/pengertian-konsep-dasar-machine-learning

Penulis :

Alvin Saputra;Richie Muliawan; Hansel Septiadi; Klemens Litano; Bayu Kanigoro