TEORI INFORMASI

TEORI INFORMASI

Dalam artikel ini, akan menjelaskan tentang teori informasi. Apa itu informasi ? Informasi merupakan hasil pengolahan data, sehingga mempunyai arti bagi pengunanya. Kuantitas informasi adalah tentang penyimpanan. Penyimpanan informasi dalam bit. Teori informasi adalah pendekatan matematika untuk mempelajari pengkodean informasi bersama dengan kuantifikasi, penyimpanan, dan komunikasi informasi. Konsep ini pertama kali diajukan oleh Claude E. Shannon sehingga Claude Shannon di sebut sebagai bapak teori informasi. Teori informasi adalah mengukur berapa banyak informasi yang ada dalam sinyal. Awalnya ditemukan untuk mempelajari pengiriman pesan dari alfabet diskrit melalu noisy channel, seperti komunikasi melalui transmisi radio.

Teori informasi adalah konsep yang sangat berguna untuk praktisi machine learning karena memungkinkan kita untuk melihat algoritma pembelajaran dari perspektif informasi-teoritik. Aplikasi dari teori informasi diantaranya adalah pada bidang linguistik, kompresi data, jaringan komputer dan bionformatika. Kasus penggunaan yang paling umum untuk teori informasi adalah untuk mencirikan distribusi probabilitas dan untuk mengukur kesamaan antara dua distribusi probabilitas.

Dalam teori informasi ada istilah redudansi informasi. Redudansi adalah sesuatu yang bisa diramalkan atau diprediksikan karena prediktabiltasnya tinggi maka informasi pun rendah. Fungsi redudansi apabila dikaitkan dengan masalah teknis, biasanya untuk membantu untuk mengatasi masalah komunikasi praktis. Contoh ketika kita mengetik pada keyboard qwerty sering muncul prediksi kata dan text prediksi/ saran otomatis (dapat di lihat pada Gambar 1)

Gambar 1 Prediksi Kata

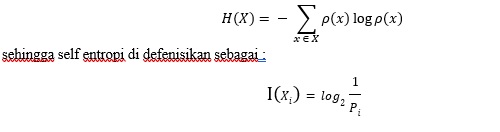

Satuan ukur informasi dinyatakan oleh entropi. Entropi mengkuantifikasi nilai ketidakpastian pada sebuah variabel data. Entropi merupakan satuan pengukuran utama dalam teori informasi. Satuan ukur informasi dinyatakan dengan bit. Entropi informasi sering dinyatakan sebagai banyaknya bit rerata yang diperlukan untuk penyimpanan dan pengiriman informasi tersebut. Dalam teori informasi, entropi memberi tahu kita jumlah informasi yang terkandung dalam peristiwa yang diamati x. Suatu peristiwa, tentu saja, memiliki probabilitasnya p(x). Satuan dari entropi H(X) adalah bits. Entropi merupakan distribusi probabilitas dalam teori informasi dan digunakan untuk mengukur tingkat homogenitas distribusi kelas dari sebuah data (data set). Semakin tinggi tingkat entropi dari sebuah data maka semakin homogen distribusi kelas pada data tersebut. Entropi pada x didefinisikan sebagai:

Contoh misalkan kita mau mengirimkan teks :”Pendidikan”, maka kita hitung probabilitas (Tabel 1).

Tabel 1. Probability

| Simbol | Kemunculan | Probabilitas (Px) |

| P | 1 | 0.1 |

| E | 1 | 0.1 |

| N | 2 | 0.2 |

| D | 2 | 0.2 |

| I | 2 | 0.2 |

| K | 1 | 0.1 |

| A | 1 | 0.1 |

| Jumlah | 10 | 1 |

Dapat dilihat dari Tabel 2 bahwa semakin tinggi probabilitas suatu simbol maka self entropynya semakin kecil.

Tabel 2 Self Entropy

| Probabilitas (Px) | Self Entropy |

| 0.1 | 3.322 |

| 0.1 | 3.322 |

| 0.2 | 2.322 |

| 0.2 | 2.322 |

| 0.2 | 2.322 |

| 0.1 | 3.322 |

| 0.1 | 3.322 |

maka dapat diperoleh entropi dari teks “Pendidikan” yang dikirimkan adalah 2.0254 dan bit yang dikirimkan 20.254.

Tabel 3 Entropi

| Probabilitas | Self Entropy | Entropy |

| 0.1 | 3.322 | 0.3322 |

| 0.1 | 3.322 | 0.3322 |

| 0.2 | 2.322 | 0.2322 |

| 0.2 | 2.322 | 0.2322 |

| 0.2 | 2.322 | 0.2322 |

| 0.1 | 3.322 | 0.3322 |

| 0.1 | 3.322 | 0.3322 |

|

Jumlah =1 |

Entropy = | 2.0254 |

| bit yang dikirimkan = | 20.254 |

Referensi :

- Alberto Porta, et al. Conditional Self-Entropy and Conditional Joint Transfer Entropy in Heart Period Variability during Graded Postural Challenge. 15 Juli 201. https://doi.org/10.1371/journal.pone.0132851

- Information Theory, Inference, and Learning Algorithms, David J. C. MacKay, Cambridge University Press, 2005.