AI Hardware Race dari TPU NPU sampai Neuromorphic Chip

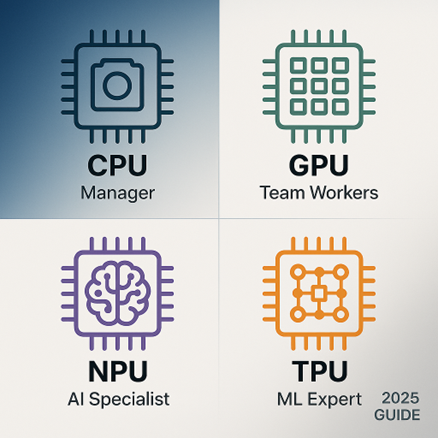

Figure 1. Evolusi arsitektur chip kecerdasan buatan dari GPU hingga TPU

Figure 1. Evolusi arsitektur chip kecerdasan buatan dari GPU hingga TPU

(https://guptadeepak.com/understanding-cpus-gpus-npus-and-tpus-a-simple-guide-to-processing-units/)

Dalam dunia kecerdasan buatan, bukan hanya algoritma yang berperang tapi juga perangkat keras yang menyalakannya. Kalau software adalah otak, maka hardware adalah tubuhnya. Dan di balik setiap kemajuan AI, dari ChatGPT hingga mobil otonom, ada perlombaan senyap yang menentukan siapa yang bisa berpikir atau setidaknya memproses data paling cepat.

Inilah AI Hardware Race, perlombaan antara raksasa teknologi untuk menciptakan chip yang makin pintar, hemat energi, dan mendekati cara kerja otak manusia.

Dari CPU dan GPU ke Era TPU

Sebelum AI jadi sepopuler sekarang, komputasi berat dilakukan di CPU otak umum komputer. Tapi CPU punya batas: ia dirancang untuk berbagai tugas, bukan tugas spesifik seperti pelatihan model AI. Lalu datang GPU (Graphics Processing Unit), awalnya dibuat untuk rendering grafis game. Karena kemampuannya melakukan ribuan operasi paralel, GPU tiba-tiba menjadi senjata utama untuk deep learning. Perusahaan seperti NVIDIA memimpin gelombang ini, menjadikan GPU sebagai jantung revolusi AI.

Namun, Google melihat peluang baru: bagaimana kalau chip dibuat khusus hanya untuk AI? Pada 2016, lahirlah TPU (Tensor Processing Unit) prosesor khusus untuk komputasi tensor di machine learning. TPU dirancang untuk mempercepat matrix multiplication, operasi paling umum dalam pelatihan neural network. Hasilnya: efisiensi energi dan kecepatan pelatihan meningkat berkali lipat.

Munculnya NPU dan Chip AI di Perangkat Mobile

Sementara TPU berkembang di pusat data, dunia mobile tidak mau ketinggalan. Smartphone modern mulai dilengkapi NPU (Neural Processing Unit) chip mini yang mampu menjalankan model AI langsung di perangkat, tanpa koneksi cloud. NPU pertama kali populer lewat Apple Neural Engine (ANE) dan Google Tensor di ponsel Pixel. Fungsinya memungkinkan fitur seperti real-time translation, portrait mode, dan voice recognition berjalan instan tanpa internet. Artinya, AI kini tidak hanya di server raksasa, tapi di genggaman pengguna.

Chip lain seperti Qualcomm Hexagon DSP dan Huawei Ascend menunjukkan bahwa AI on device adalah tren yang tidak bisa diabaikan. Selain privasi lebih aman, pendekatan ini juga menekan latensi dan konsumsi daya.

Figure 2. Arsitektur chip neuromorfik yang meniru sinapsis otak manusia

(https://www.intel.com/content/www/us/en/research/neuromorphic-computing.html)

Neuromorphic Chip: Meniru Otak Manusia

Tahap berikutnya dalam perlombaan ini bukan hanya membuat chip cepat tapi chip yang bisa berpikir seperti otak manusia. Inilah konsep neuromorphic computing, di mana arsitektur chip dirancang untuk meniru neuron dan sinapsis biologis. Proyek seperti Intel Loihi, IBM TrueNorth, dan BrainChip Akida mencoba membangun system yang belajar dan beradaptasi secara alami. Alih-alih sekadar menghitung, chip ini bisa mengingat pola, menghemat energi, dan bahkan “lupa” informasi yang tidak penting persis seperti otak manusia.

Keunggulannya? Konsumsi daya yang sangat rendah, cocok untuk AI yang berjalan di robot, drone, atau perangkat IoT skala kecil. Namun, neuromorphic masih dalam tahap riset awal. Tantangannya bukan hanya teknologi, tapi juga cara berpikir baru dalam memprogram mesin yang tidak lagi deterministik seperti komputer biasa.

Siapa yang Memimpin Perlombaan?

| Jenis Chip | Fokus Utama | Pemain Kunci | Aplikasi |

| GPU | Komputasi paralel umum | NVIDIA, AMD | Pelatihan AI skala besar |

| TPU | Optimasi tensor ops | Pelatihan dan inferensi ML | |

| NPU | Edge AI dan mobile | Apple, Qualcomm, Huawei | AI on-device |

| Neuromorphic | Simulasi neuron biologis | Intel, IBM, BrainChip | Riset & robotika |

Masing-masing pemain punya pendekatan unik. NVIDIA memperluas GPU dengan AI cores, Google fokus pada efisiensi TPU di cloud, sementara Intel dan IBM bereksperimen dengan arsitektur otak digital.

Perlombaan yang Lebih dari Sekadar Kecepatan

Perlombaan hardware AI ini bukan sekadar siapa yang lebih cepat memproses data, tapi siapa yang paling efisien memahami kompleksitas dunia nyata. Setiap generasi chip membawa kita sedikit lebih dekat ke mimpi lama: mesin yang bisa belajar dan beradaptasi seperti manusia.

Namun di balik kemegahan inovasi, ada pelajaran penting bahwa setiap lonjakan performa lahir dari kolaborasi antara ide dan infrastruktur. Tanpa riset akademik, komunitas open source, dan visi manusia di baliknya, semua chip itu hanyalah potongan silikon tanpa makna.

Penulis:

Emmanuel Daniel Widhiarto, S.Kom – FDP Scholar

Referensi

Gupta Deepak. (2025). Understanding CPUs GPUs NPUs and TPUs A Simple Guide to Processing Units. https://guptadeepak.com/understanding-cpus-gpus-npus-and-tpus-a-simple-guide-to-processing-units/

NVIDIA. (2023). GPU Architecture for Deep Learning. https://developer.nvidia.com/deep-learning

Apple Developer. (2024). Apple Neural Engine Documentation. https://developer.apple.com/documentation/coreml

Intel Labs. (2023). Neuromorphic Computing Research. https://www.intel.com/content/www/us/en/research/neuromorphic-computing.html

IBM Research. (2024). What is neuromorphic computing? https://www.ibm.com/think/topics/neuromorphic-computing