Penerapan Deep Learning untuk Pengenalan Bahasa Isyarat Indonesia (BISINDO) sebagai Upaya Mewujudkan Pendidikan Inklusif

(Source: Generated by Gemini)

Bahasa isyarat adalah jembatan utama komunikasi bagi komunitas Tuli. Di Indonesia, Bahasa Isyarat Indonesia (BISINDO) digunakan dalam konteks pendidikan, keluarga, hingga layanan publik. Namun, terbatasnya jumlah juru bahasa isyarat (JBI) dan sebarannya yang tidak merata menyebabkan banyak teman Tuli masih kesulitan mengakses layanan dasar seperti konsultasi di rumah sakit hingga mengikuti perkuliahan.

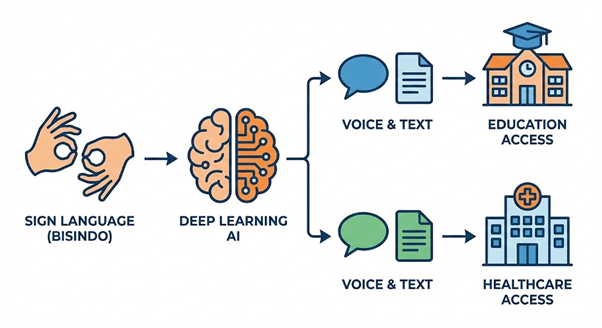

Perkembangan deep learning membuka peluang baru: menghadirkan sistem yang mampu mengenali dan menerjemahkan bahasa isyarat secara otomatis, sehingga dapat membantu menjembatani komunikasi Tuli–dengar. Artikel ini membahas secara ringkas bagaimana deep learning diterapkan untuk pengenalan BISINDO.

Tantangan Komunikasi dan Kesenjangan Akses

Tantangan utama yang dihadapi komunitas Tuli di Indonesia antara lain:

- Keterbatasan JBI tersertifikasi dan distribusi yang tidak merata, terutama di luar kota besar.

- Minimnya tenaga pendidik yang benar-benar menguasai bahasa isyarat.

- Keterbatasan media pembelajaran BISINDO yang interaktif dan mudah diakses keluarga maupun masyarakat umum.

Akibatnya, banyak interaksi penting seperti saat konsultasi medis, pengurusan dokumen, atau proses belajar tidak berlangsung secara optimal. Di sinilah teknologi pengenalan bahasa isyarat berbasis deep learning berpotensi menjadi assistive technology yang mendukung inklusivitas, tanpa menggantikan peran manusia (JBI).

Static vs Dynamic Gesture: Dua Dunia dalam BISINDO

Secara teknis, gesture dalam bahasa isyarat dapat dibagi menjadi dua:

- Static gesture

- Posisi tangan berhenti pada satu pose tertentu (misalnya huruf A–Z, angka).

- Cocok dimodelkan sebagai masalah klasifikasi citra.

- Dynamic gesture

- Rangkaian gerakan dari waktu ke waktu (kata, frasa, kalimat).

- Lebih cocok dimodelkan sebagai pengenalan urutan video (sequence modeling).

Banyak penelitian awal BISINDO berfokus pada static gesture karena lebih sederhana untuk dikumpulkan dan diproses. Seiring berkembangnya metode dan dataset, penelitian mulai melangkah ke level kata dan kalimat.

Penerapan Deep Learning pada BISINDO

- Pengenalan Alfabet dan Angka (Static Gesture)

Untuk pengenalan huruf dan angka BISINDO, model yang paling sering digunakan adalah:

- Convolutional Neural Network (CNN) kustom, atau adaptasi arsitektur populer seperti AlexNet dan VGG-16.

- Model ringan (MobileNetV2) yang cocok untuk implementasi di perangkat bergerak.

- Vision Transformer (ViT) yang di-fine-tune pada dataset citra alfabet BISINDO.

Berbagai studi melaporkan akurasi tinggi (di atas 95–98%) pada tugas klasifikasi huruf/angka BISINDO, terutama ketika data dilengkapi dengan augmentasi dan pencahayaan relatif terkontrol. Di tahap ini, fokus mulai bergeser dari “bisa mengenali atau tidak” menjadi “apakah model cukup ringan dan robust untuk dipakai di dunia nyata?”.

- Pengenalan Kata BISINDO (Dynamic Gesture)

Untuk word-level BISINDO, kombinasi CNN + LSTM/GRU menjadi pola yang dominan:

- CNN mengekstrak fitur spasial dari tiap frame video.

- LSTM/GRU menangkap pola temporal gerakan.

Beberapa penelitian menunjukkan bahwa CNN-LSTM mampu mengungguli metode klasik seperti Dynamic Time Warping (DTW) atau GLVQ, terutama ketika jumlah kata mulai meningkat. Tantangan utama yang sering muncul adalah:

- Ukuran dataset video yang masih terbatas.

- Evaluasi yang belum sepenuhnya signer-independent (model dilatih dan diuji pada penutur yang sama).

- Pendekatan Pose-Based (MediaPipe + RNN)

Tren lebih baru adalah menggunakan landmark pose:

- Library seperti MediaPipe Holistic mengekstrak koordinat titik-titik kunci tangan, tubuh, dan wajah.

- Koordinat ini kemudian diproses oleh LSTM/GRU sebagai sekuens vektor.

Pendekatan ini mengurangi ketergantungan pada background dan pencahayaan, karena model bekerja di atas representasi “kerangka” (skeleton) gerakan. Sejumlah penelitian BISINDO menunjukkan akurasi >95% untuk kosakata kata menggunakan kombinasi landmark + LSTM, sekaligus memungkinkan model yang lebih ringan untuk dijalankan di perangkat dengan sumber daya terbatas.

- Menuju Sentence-Level BISINDO

Untuk kalimat (continuous sign), beberapa peneliti mulai menggunakan 3D CNN + LSTM / BiLSTM untuk menangkap informasi spasio-temporal langsung dari blok video. Hasil awal cukup menjanjikan, tetapi korpus kalimat BISINDO masih kecil dan domain kalimat cenderung sempit. Ruang riset terbuka lebar untuk eksplorasi.

Tantangan dan Arah Pengembangan ke Depan

Beberapa tantangan yang masih perlu dijawab antara lain:

- Dataset publik BISINDO yang besar, teranotasi rapi, dan mencakup multi-signer serta beragam konteks.

- Evaluasi signer-independent yang sistematis, sehingga model benar-benar siap digunakan oleh pengguna baru.

- Integrasi end-to-end BISINDO → teks → suara → kembali ke isyarat dalam satu platform yang ramah pengguna.

- Kolaborasi erat dengan komunitas Tuli, bukan hanya sebagai “penyedia data”, tetapi sebagai mitra dalam desain, pengujian, dan evaluasi etis.

Dengan arah pengembangan yang tepat, pengenalan BISINDO berbasis deep learning tidak hanya menjadi topik riset menarik, tetapi juga berkontribusi nyata terhadap tercapainya pendidikan inklusif dan berkurangnya kesenjangan sosial di Indonesia.

Penulis:

Maulin Nasari S.Kom., M.Kom

Referensi:

- Dwijayanti, M., dkk. (2021). Indonesia Sign Language Recognition using Convolutional Neural Network. International Journal of Advanced Computer Science and Applications (IJACSA).

- Aljabar, R., & Suharjito. (2020). Word-level Indonesian Sign Language Recognition with CNN-LSTM. Advances in Science, Technology and Engineering Systems Journal (ASTESJ).

- Handhika, J., dkk. (2018). Sign Language Gesture Recognition using Generalized Learning Vector Quantization. Journal of Physics: Conference Series (JPCS) / 2018 Third International Conference on Informatics and Computing (ICIC, IEEE).

- Agustin, D., dkk. (2024). BISINDO Sign Language Recognition using MediaPipe Holistic and LSTM with Text-to-Speech Output. Jurnal Teknik Informatika dan Komputer (JUTIF).

- Agustiansyah, M., & Kurniadi, D. (2025). Vision Transformer for BISINDO Alphabet Recognition. Jurnal Ilmiah Sistem dan Teknologi Informasi (JISTICS).

- Utomo, A., dkk. (2025). Indonesian Sign Language System (ISLS) Gesture Recognition using MediaPipe Hands and LSTM. Journal of Intelligent and Web Engineering (JIWE).

- Joan, C., dkk. (2023). BISINDO Hand-Sign Detection Using Transfer Learning. Prosiding konferensi IEEE (ICRAIE).

- Kindya, A., dkk. (2025). Word-Level BISINDO: A Novel Video Indonesian Sign Language Dataset and Baseline Methods. Procedia Computer Science.

- United Nations. (2015). Transforming Our World: The 2030 Agenda for Sustainable Development. United Nations.

- World Federation of the Deaf. (berbagai tahun). Position Papers on Sign Language Rights and Accessibility.