Imbalanced Dataset

Imbalanced Data

Kelas yang tidak seimbang adalah masalah umum dalam klasifikasi pembelajaran mesin di mana terdapat rasio yang tidak proporsional di setiap kelas. Ketidakseimbangan kelas dapat ditemukan di berbagai bidang termasuk diagnosa medis, penyaringan spam, dan deteksi penipuan, klasifikasi emosi dll.

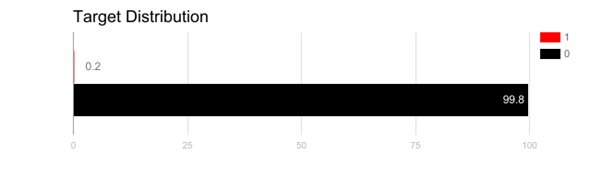

Bagaimana contoh data yang tidak seimbang yaitu seperti deteksi penipuan di perbankan. Data ini merupakan kejadian langka dimana hanya 1% kemungkinan terjadinya penipuan diperbankan. Sebagian besar algoritma pembelajaran mesin tidak bekerja dengan baik dengan dataset tidak seimbang. Salah satu tiga teknik berikut dapat membantu, untuk melatih classifier untuk mendeteksi kelas abnormal/imbalanced.

- Gunakan metrik evaluasi yang tepat.

Menerapkan metrik evaluasi yang tidak tepat untuk model yang dihasilkan menggunakan data yang tidak seimbang bisa berbahaya. Bayangkan jika data pelatihan adalah yang diilustrasikan dalam grafik di atas. Jika akurasi digunakan untuk mengukur ketepatan suatu model, model yang mengklasifikasikan semua sampel pengujian menjadi “0” akan memiliki akurasi yang sangat baik (99,8%), tetapi jelas, model ini tidak akan memberikan informasi berharga.

Dalam hal ini, metrik evaluasi alternatif lain dapat diterapkan seperti:

- Presisi / Spesifisitas: berapa banyak instance terpilih yang relevan.

- Recall / Sensitivitas: berapa banyak instance yang relevan dipilih.

- F1 Score: rata-rata harmonis dari presisi dan recall.

- MCC: koefisien korelasi antara klasifikasi biner yang diamati dan yang diprediksi.

- AUC: hubungan antara tingkat true-positive dan false positive.

- Resample set pelatihan

- Undersampling menyeimbangkan dataset dengan mengurangi ukuran kelas yang berlimpah. Metode ini digunakan ketika jumlah data mencukupi. Dengan menjaga semua sampel di kelas langka dan secara acak memilih jumlah sampel yang sama di kelas berlimpah, dataset baru yang seimbang dapat diambil untuk pemodelan lebih lanjut.

- Oversampling digunakan ketika jumlah data tidak mencukupi. Mencoba menyeimbangkan dataset dengan meningkatkan ukuran sampel langka. Daripada membuang sampel berlimpah, sampel langka baru dihasilkan dengan menggunakan mis. SMOTE (Sintetis Minoritas Sampling Teknik).Tidak ada keunggulan absolut dari satu metode resampling atas yang lain. Penerapan kedua metode ini bergantung pada use case yang digunakan dan dataset itu sendiri. Kombinasi over-dan under-sampling sering berhasil juga.

- Gunakan K-fold Cross-Validation dengan cara yang benar

Patut dicatat bahwa validasi silang harus diterapkan dengan benar saat menggunakan oversampling untuk mengatasi masalah ketidakseimbangan.Perlu diingat bahwa pengambilan oversampling mengambil sampel langka yang diamati dan menerapkan bootstrap untuk menghasilkan data acak baru berdasarkan fungsi distribusi. Jika Cross-Validation diterapkan setelah oversampling, pada dasarnya yang dilakukan adalah overfitting model dengan hasil bootstrap buatan tertentu.Itulah sebabnya Cross-Validation harus selalu dilakukan sebelum oversampling data, seperti halnya bagaimana pemilihan fitur harus dilaksanakan. Hanya dengan melakukan resampling data berulang kali, keacakan dapat dimasukkan ke dalam dataset untuk memastikan bahwa tidak akan ada masalah overfitting.

Daftar Pustaka

https://designmodo.com/interaction-design/

https://www.interaction-design.org/literature/topics/interaction-design

Interaction Design, Beyond Human-Computer Interaction (2019)

https://www.kdnuggets.com/2017/06/7-techniques-handle-imbalanced-data.html