Memahami Explainable AI: Transparansi di Balik Kecerdasan Buatan

Artificial Intelligence (AI) atau kecerdasan buatan semakin menjadi bagian tak terpisahkan dari kehidupan kita, mulai dari rekomendasi konten di media sosial hingga sistem deteksi penyakit dan pengambilan keputusan bisnis. Penggunanya pun menyebar luas mulai dari pelajar hingga profesional. Namun, seiring meningkatnya penggunaan model AI yang kompleks seperti deep learning, muncul tantangan besar, yaitu bagaimana kita bisa memahami dan mempercayai keputusan yang diambil oleh model ini? Di sinilah kemudian konsep Explainable AI (XAI) diperkenalkan dan sangat berperan.

Apa Itu Explainable AI?

Explainable AI adalah pendekatan dalam pengembangan sistem kecerdasan buatan (AI) yang bertujuan untuk membuat hasil dan proses pengambilan keputusan model AI dapat dimengerti oleh manusia. XAI berfokus pada transparansi, interpretabilitas, dan akuntabilitas model AI, terutama model-model kompleks seperti neural network, ensemble methods, hingga model-model deep learning yang sering dianggap sebagai “black box”. Black box dalam hal ini didefinisikan sebagai kondisi di mana user hanya mengetahui input dan output-nya saja, tetapi proses dibalik sistem tersebut tidak diketahui.

Dengan XAI, pengguna tidak hanya mengetahui hasil akhir, tetapi juga mendapatkan alasan di balik keputusan tersebut. Contoh sederhananya adalah dalam konteks spam classification, pada umumnya ketika kita tidak menggunakan XAI, kita hanya mengetahui suatu pesan atau teks merupakan spam atau tidak. Namun, dengan XAI kita dapat mengetahui alasan kenapa suatu teks tersebut dikategorikan sebagai spam, misalnya karena mengandung kata-kata tertentu.

Mengapa XAI Penting?

- Kepercayaan Pengguna: Tanpa penjelasan, pengguna mungkin enggan mempercayai sistem AI, terutama dalam domain yang sifatnya kritis seperti kesehatan, hukum, atau keuangan.

- Audit dan Regulasi: XAI membantu memenuhi regulasi yang mengharuskan transparansi algoritma, seperti yang ada pada GDPR di Eropa.

- Debugging dan Pengembangan Model: Penjelasan yang dihasilkan akan memudahkan developer untuk mengetahui apakah model telah belajar pola yang benar atau justru bias.

- Etika: Salah satu pembicaraan yang menjadi concern saat ini terkait AI adalah aspek etika. Dengan penjelasan atau transparansi hasil, kita akan dapat setidaknya meminimalisir kemungkinan pelanggaran etika.

Teknik Umum dalam Explainable AI

Terdapat dua pendekatan utama dalam XAI:

- Model Interpretable by Design: Menggunakan model yang memang sudah mudah dipahami seperti decision tree, linear regression, atau rule-based model.

- Post-hoc Explanation: Memberikan interpretasi setelah model dilatih, biasanya untuk model kompleks seperti deep neural networks.

Beberapa teknik populer:

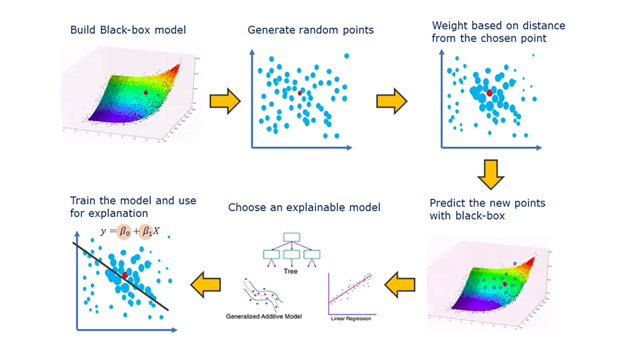

- LIME (Local Interpretable Model-Agnostic Explanations)

LIME menjelaskan prediksi model dengan membangun model interpretable (misalnya regresi linear) di sekitar satu instance yang ingin dijelaskan. Berikut adalah potongan kode contoh untuk implementasi LIME dengan python. Pada gambar di bawah juga dijabarkan langkah-langkah dari algoritma LIME.

from lime.lime_text import LimeTextExplainer

explainer = LimeTextExplainer(class_names=[‘negatif’, ‘positif’])

explanation = explainer.explain_instance(text_instance, model.predict_proba, num_features=6)

explanation.show_in_notebook()

Sumber: https://medium.com/data-science/lime-explain-machine-learning-predictions-af8f18189bfe

- SHAP (SHapley Additive exPlanations)

SHAP pada awalnya dikembangkan menggunakan game theory untuk menghitung kontribusi tiap fitur terhadap prediksi model secara global. Perbedaan yang mendasari antara LIME dan SHAP adalah bahwa SHAP dapat menjelaskan kontribusi fitur secara global, sedangkan LIME hanya menjelaskan secara lokal atau per-instance saja.

import shap

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X_test)

shap.summary_plot(shap_values, X_test)

Sumber: https://github.com/shap/shap

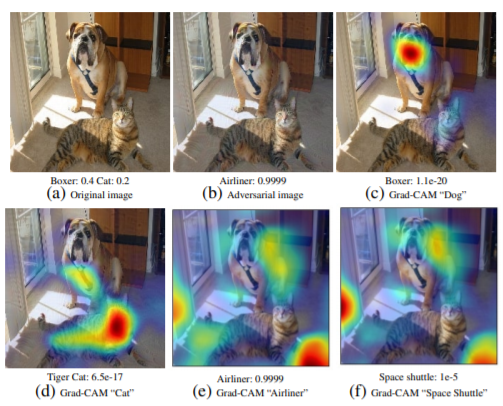

- Grad-CAM (untuk Computer Vision)

Digunakan untuk model berbasis CNN, Grad-CAM menghasilkan visualisasi heatmap untuk menunjukkan bagian mana dari gambar yang paling mempengaruhi hasil keputusan model.

Sumber: https://medium.com/@aimldl1984/explainable-ai-grad-cam-8acd04dd2dd3

Contoh Aplikasi Nyata XAI

- Kesehatan: Menjelaskan diagnosis penyakit dari model berbasis citra medis.

- Finansial: Memberikan alasan kenapa suatu pengajuan pinjaman ditolak.

- E-commerce: Menjelaskan mengapa suatu produk direkomendasikan ke pengguna.

- Kebijakan Publik: Memastikan sistem prediktif tidak diskriminatif terhadap kelompok tertentu.

Kesimpulan

Explainable AI adalah elemen penting untuk membawa AI ke arah yang lebih etis, transparan, dan dapat dipercaya. Dengan meningkatnya kompleksitas model, kebutuhan untuk memahami cara kerja AI menjadi semakin krusial. Baik developer, user, maupun pemangku kebijakan perlu memahami dan menerapkan prinsip XAI agar sistem yang dibangun tidak hanya cerdas, tetapi juga dapat dipertanggungjawabkan.

Penulis

Muhammad Alfhi Saputra

Referensi