Automation Paradox Ketika Mesin Makin Pintar Manusia Justru Makin Dibutuhkan

Gambar 1. Automation paradox (https://www.linkedin.com/pulse/automation-paradox-how-increased-efficiency-can-lead-greater-gupta-6kyyc)

Gambar 1. Automation paradox (https://www.linkedin.com/pulse/automation-paradox-how-increased-efficiency-can-lead-greater-gupta-6kyyc)

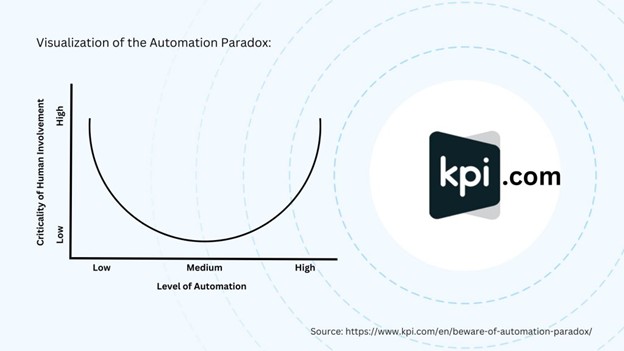

Di tengah dunia yang semakin bergantung pada kecerdasan buatan dan sistem otomatis, kita sering mendengar klaim bahwa teknologi akan menggantikan manusia. Namun berbagai penelitian modern menunjukkan kenyataan yang jauh lebih menarik. Semakin tinggi tingkat otomatisasi sebuah sistem, semakin besar ketergantungan kita pada manusia untuk mengawasi, menilai, dan mengambil keputusan kritis. Fenomena inilah yang dikenal sebagai Automation Paradox, kondisi ketika mesin menggantikan banyak pekerjaan rutin tetapi justru memperluas peran manusia dalam tugas yang memerlukan penilaian tinggi, pengawasan, dan penyelesaian masalah kompleks.

Ketika Kepercayaan terhadap Otomatisasi Menjadi Pedang Bermata Dua

Dalam banyak kasus, manusia cenderung mempercayai sistem otomatis secara berlebihan. Studi oleh Yang, Schemanske, dan Searle (2021) menunjukkan bahwa kepercayaan manusia kepada otomatisasi tidak stabil. Justru kegagalan kecil pada sistem otomatis memiliki dampak yang lebih kuat terhadap psikologi pengguna dibanding keberhasilan yang berulang. Ketika sistem tampak akurat dan konsisten, manusia cenderung berhenti mempertanyakan hasilnya. Tetapi ketika kesalahan muncul, pengguna bisa kehilangan kemampuan untuk mengevaluasi situasi karena terlalu lama tidak terlibat dalam proses manual. Sistem otomatis juga dapat menyebabkan apa yang disebut dengan automation inertia. Akash, McMahon, Reid, dan Jain (2020) menemukan bahwa kepercayaan dan kebergantungan dapat berubah secara dinamis selama interaksi pengguna dengan AI. Oleh karena itu mereka mengusulkan model transparansi otomatisasi yang berubah-ubah berdasarkan kondisi. Saat tugas berjalan mulus, sistem tidak perlu menampilkan detail yang berlebihan. Namun ketika terjadi ketidakpastian, AI harus segera meningkatkan informasi kepada pengguna agar manusia tetap memiliki kontrol penuh.

Gambar 2. Visualization of the Automation Paradox (https://www.kpi.com/en/beware-of-automation-paradox/)

Ketika Mesin Menangani Detail, Manusia Menangani Krisis

Salah satu konsekuensi terbesar dari otomatisasi adalah menurunnya keterampilan manual manusia. Hal ini menjadi masalah ketika sistem mendadak gagal. Dalam studi dari Halvachi dan rekan-rekannya (2023), ditemukan bahwa semakin sering manusia menyerahkan tugas kepada otomatisasi, semakin rendah tingkat kesadaran situasional mereka ketika berhadapan dengan kondisi darurat. Otomatisasi memang mengurangi beban kognitif, tetapi juga membuat manusia kehilangan kedekatan terhadap proses yang sedang berjalan. Masalah ini sangat nyata pada sektor keamanan siber, penerbangan, hingga perawatan medis. Penelitian terbaru oleh Tilbury dan Flowerday (2024) pada Security Operation Centers menunjukkan bahwa analis keamanan cenderung terlalu percaya pada sistem otomatis hingga mereka tidak lagi melakukan validasi terhadap peringatan sistem. Ketika serangan nyata terjadi, tim menjadi lebih lambat merespon karena proses manual yang seharusnya dilakukan secara konsisten tidak lagi menjadi kebiasaan. Di sinilah Automation Paradox memperlihatkan dampak nyata. Mesin semakin cepat dan akurat, tetapi ketika sistem salah membaca situasi, manusia harus mengatasi masalah yang jauh lebih sulit dengan waktu jauh lebih sedikit.

Gambar 3. Kolaborasi antara manusia dan robot (https://nttdata-solutions.com/es/blog/the-automation-paradox/)

Otomatisasi yang Etis dan Human Centered

Otomatisasi yang ideal bukan hanya meningkatkan kecepatan kerja, tetapi juga memperjelas tanggung jawab manusia dalam prosesnya. Douer dan Meyer (2018) memperkenalkan Responsibility Quantification Model yang memetakan seberapa besar tanggung jawab manusia dalam sistem otomatis yang kompleks. Model ini menunjukkan bahwa ketika peran manusia tidak didefinisikan dengan jelas, tingkat tanggung jawab mereka terhadap hasil sistem menjadi rendah meskipun mereka berada di posisi pengawasan. Artinya, otomatisasi bisa mengaburkan batas peran manusia tanpa disadari pengguna maupun perancang sistemnya. Di sisi lain pemimpin bisnis teknologi juga mulai menyadari bahwa otomatisasi tidak bisa berjalan sepenuhnya tanpa memperhitungkan aspek kemanusiaan. Bremen (2023) menekankan bahwa AI generatif seharusnya menjadi alat kolaboratif, bukan sistem yang menggantikan manusia sepenuhnya. Dengan pendekatan human centered automation sistem dapat dirancang untuk mendukung pengambilan keputusan manusia, menyediakan penjelasan yang mudah dipahami, serta tetap memberi ruang bagi manusia untuk mempertahankan keterampilan penting.

Kesimpulan

Automation Paradox mengingatkan kita bahwa otomatisasi bukan perjalanan satu arah menuju penghapusan peran manusia. Sebaliknya era baru otomatisasi justru mempertegas bahwa manusia adalah bagian penting dalam loop. Tugas manual mungkin hilang tetapi tanggung jawab strategis, pengawasan kritis, dan penilaian etis menjadi semakin penting. Tujuan akhir bukanlah menciptakan dunia yang sepenuhnya dijalankan mesin, tetapi menciptakan kolaborasi yang membuat mesin dan manusia saling mengisi kekurangan masing-masing. Dengan memahami Automation Paradox, perusahaan dan pengembang teknologi dapat membangun sistem otomatis yang lebih aman, lebih transparan, dan lebih bertanggung jawab. Dunia yang semakin otomatis bukanlah dunia tanpa manusia, tetapi dunia yang membutuhkan manusia lebih dari sebelumnya.

Penulis

Daniel Kevin Jhon Feko Wahyudi, S.Kom – FDP Scholar

Referensi

Akash, K., McMahon, G., Reid, T., & Jain, N. (2020). Human Trust based Feedback Control Dynamically Varying Automation Transparency to Optimize Human Machine Interactions. arXiv. https://arxiv.org/abs/2006.16353

Bremen, J. M. (2023). The Human Factor in Generative AI and the Automation Paradox. Forbes. https://www.forbes.com/sites/johnbremen/2023/07/27/the-human-factor-in-generative-ai-and-the-automation-paradox

Douer, N., & Meyer, J. (2018). The Responsibility Quantification (ResQu) Model of Human Interaction with Automation. arXiv. https://arxiv.org/abs/1810.12644

Halvachi, H., Shirehjini, A. A. N., Kakavand, Z., Hashemi, N., & Shirmohammadi, S. (2023). The Effects of Interaction Conflicts Levels of Automation and Frequency of Automation on Human Automation Trust and Acceptance. arXiv. https://arxiv.org/abs/2307.05512

Tilbury, J., & Flowerday, S. (2024). Automation Bias and Complacency in Security Operation Centers. Computers, 13(7). https://www.researchgate.net/publication/381973037

Yang, X., Schemanske, C., & Searle, K. (2021). Dynamics of Trust in Human Automation Interaction. arXiv. https://arxiv.org/abs/2108.13883